Aria Operations 8.16 の Hot Fix 1 がリリースされました。

kb.vmware.com

適用対象としては、

VMware Aria Operations 8.16 Hot Fix 1 can be applied to any 8.16.x environment.

と 8.16.x なら何でもこざれですが、この時点で 8.16 のリリースとしては以下。

- 8.16

- 8.16.1

ところでこれ、どちらに当てても結果は同じ中身になるんだっけ…という検証。

TL;DR

どのバージョンに Hot Fix を適用しても結果は同じものができる。

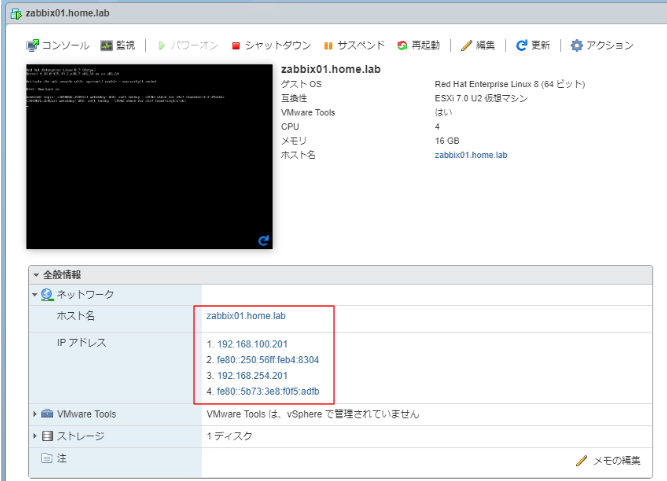

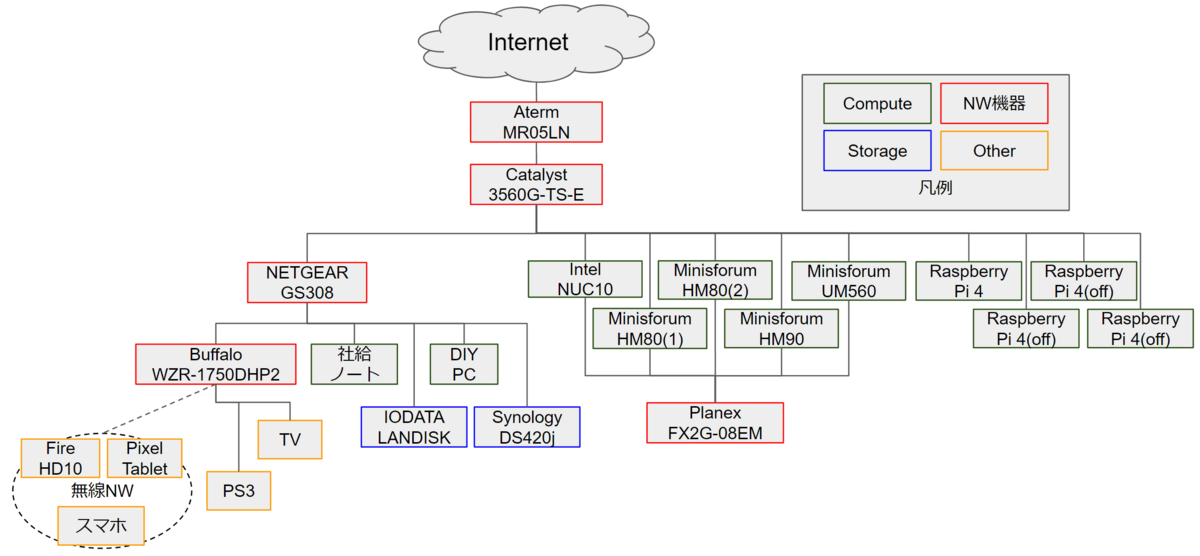

環境

Aria Operations を 2つ立てます。

一つは 8.16.0

もう一つは 8.16.1

これでアップグレード後のバージョン/ビルドを比較して…で良さそうですが、

せっかくならもう少し細かく OS 内のパッケージでも比較する。

Aria Operations 8.16

admin@vrops01 [ ~ ]$ rpm -qa | sort ansible-2.14.12-1.ph4.noarch ansible-community-general-5.6.0-3.ph4.noarch ansible-posix-1.4.0-3.ph4.noarch apr-1.7.2-1.ph4.x86_64 apr-util-1.6.3-1.ph4.x86_64 attr-2.4.48-2.ph4.x86_64 audit-2.8.5-30.ph4.x86_64 autogen-libopts-5.18.16-4.ph4.x86_64 bash-5.0-4.ph4.x86_64 bc-1.07.1-4.ph4.x86_64 bindutils-9.16.42-4.ph4.x86_64 bridge-utils-1.6-1.ph4.x86_64 btrfs-progs-5.7-3.ph4.x86_64 bzip2-1.0.8-4.ph4.x86_64 bzip2-libs-1.0.8-4.ph4.x86_64 ca-certificates-20201001-4.ph4.x86_64 ca-certificates-pki-20201001-4.ph4.x86_64 cairo-1.17.2-6.ph4.x86_64 c-ares-1.19.1-1.ph4.x86_64 chkconfig-1.9-3.ph4.x86_64 chromium-119.0.6045.176-2.ph4.x86_64 cifs-utils-6.13-2.ph4.x86_64 cloud-init-23.4-3.ph4.noarch cmocka-1.1.5-3.ph4.x86_64 coreutils-selinux-9.1-2.ph4.x86_64 cpio-2.13-9.ph4.x86_64 cracklib-2.9.7-4.ph4.x86_64 cracklib-dicts-2.9.7-4.ph4.x86_64 cronie-1.5.5-1.ph4.x86_64 curl-8.1.2-7.ph4.x86_64 curl-libs-8.1.2-7.ph4.x86_64 cyrus-sasl-2.1.27-7.ph4.x86_64 dbus-1.13.18-3.ph4.x86_64 device-mapper-2.03.10-3.ph4.x86_64 device-mapper-event-2.03.10-3.ph4.x86_64 device-mapper-event-libs-2.03.10-3.ph4.x86_64 device-mapper-libs-2.03.10-3.ph4.x86_64 dhcp-client-4.4.2-6.ph4.x86_64 dhcp-libs-4.4.2-6.ph4.x86_64 distrib-compat-0.1-2.ph4.x86_64 dracut-050-13.ph4.x86_64 drpm-0.5.0-6.ph4.x86_64 e2fsprogs-1.46.5-2.ph4.x86_64 e2fsprogs-libs-1.46.5-2.ph4.x86_64 elfutils-0.181-7.ph4.x86_64 elfutils-libelf-0.181-7.ph4.x86_64 ethtool-5.10-1.ph4.x86_64 expat-2.2.9-11.ph4.x86_64 expat-libs-2.2.9-11.ph4.x86_64 file-5.39-2.ph4.x86_64 file-libs-5.39-2.ph4.x86_64 filesystem-1.1-4.ph4.x86_64 findutils-4.7.0-1.ph4.x86_64 finger-0.17-3.ph4.x86_64 flex-2.6.4-3.ph4.x86_64 fontconfig-2.13.1-5.ph4.x86_64 fping-5.0-1.ph4.x86_64 freetype2-2.13.0-1.ph4.x86_64 fuse-2.9.9-1.ph4.x86_64 fuse3-3.9.4-4.ph4.x86_64 gawk-5.1.1-1.ph4.x86_64 gc-8.0.4-2.ph4.x86_64 gdbm-1.19-1.ph4.x86_64 gettext-0.21-3.ph4.x86_64 glib-2.68.4-1.ph4.x86_64 glibc-2.32-14.ph4.x86_64 glibc-i18n-2.32-14.ph4.x86_64 glibc-iconv-2.32-14.ph4.x86_64 glibc-lang-2.32-14.ph4.x86_64 gmp-6.2.0-1.ph4.x86_64 gnupg-2.2.23-4.ph4.x86_64 gnutls-3.7.10-1.ph4.x86_64 gpg-pubkey-66fd4949-4803fe57 gpg-pubkey-8a6a826d-596882ca grep-3.4-2.ph4.x86_64 grub2-2.06-12.ph4.x86_64 grub2-efi-image-2.06-12.ph4.x86_64 grub2-theme-4.0-2.ph4.noarch guile-2.0.13-4.ph4.x86_64 gzip-1.12-2.ph4.x86_64 haveged-1.9.13-2.ph4.x86_64 httpd-2.4.58-2.ph4.x86_64 httpd-mod_jk-1.2.48-9.ph4.x86_64 iana-etc-2.30-2.ph4.noarch initramfs-2.0-7.ph4.x86_64 initscripts-10.04-2.ph4.x86_64 inotify-tools-3.13-2.ph4.x86_64 ipcalc-0.4.1-1.ph4.x86_64 iproute2-5.10.0-4.ph4.x86_64 iptables-1.8.9-3.ph4.x86_64 iputils-20200821-3.ph4.x86_64 irqbalance-1.7.0-4.ph4.x86_64 jansson-2.13.1-1.ph4.x86_64 kbd-2.3.0-2.ph4.x86_64 kmod-27-1.ph4.x86_64 krb5-1.17-10.ph4.x86_64 less-551-2.ph4.x86_64 libacl-2.2.53-2.ph4.x86_64 libaio-0.3.110-3.ph4.x86_64 libarchive-3.4.3-10.ph4.x86_64 libassuan-2.5.3-2.ph4.x86_64 libatomic_ops-7.6.10-2.ph4.x86_64 libcap-2.43-3.ph4.x86_64 libcap-ng-0.8-2.ph4.x86_64 libedit-3.1.20210910-2.ph4.x86_64 libestr-0.1.11-2.ph4.x86_64 libevent-2.1.12-1.ph4.x86_64 libfastjson-0.99.8-1.ph4.x86_64 libffi-3.3-1.ph4.x86_64 libgcc-10.2.0-2.ph4.x86_64 libgcrypt-1.9.4-2.ph4.x86_64 libgomp-10.2.0-2.ph4.x86_64 libgpg-error-1.39-1.ph4.x86_64 libksba-1.4.0-4.ph4.x86_64 liblogging-1.0.6-2.ph4.x86_64 libltdl-2.4.6-3.ph4.x86_64 libmicrohttpd-0.9.76-2.ph4.x86_64 libmnl-1.0.4-4.ph4.x86_64 libmspack-0.10.1alpha-3.ph4.x86_64 libnftnl-1.2.1-1.ph4.x86_64 libnsl-1.3.0-2.ph4.x86_64 libnuma-2.0.14-3.ph4.x86_64 libpcap-1.10.0-1.ph4.x86_64 libpng-1.6.37-2.ph4.x86_64 libpwquality-1.4.2-3.ph4.x86_64 librelp-1.8.0-5.ph4.x86_64 libseccomp-2.5.0-3.ph4.x86_64 libselinux-3.3-1.ph4.x86_64 libsepol-3.3-1.ph4.x86_64 libsolv-0.7.19-5.ph4.x86_64 libssh2-1.11.0-1.ph4.x86_64 libstdc++-10.2.0-2.ph4.x86_64 libtasn1-4.14-2.ph4.x86_64 libtirpc-1.2.6-4.ph4.x86_64 libtool-2.4.6-3.ph4.x86_64 libunistring-0.9.10-2.ph4.x86_64 libuv-1.45.0-1.ph4.x86_64 libX11-1.8.5-2.ph4.x86_64 libXau-1.0.9-1.ph4.x86_64 libxcb-1.15-1.ph4.x86_64 libXdmcp-1.1.3-1.ph4.x86_64 libXext-1.3.4-3.ph4.x86_64 libxml2-2.9.12-12.ph4.x86_64 libxml2-devel-2.9.12-12.ph4.x86_64 libxslt-1.1.34-7.ph4.x86_64 libyaml-0.2.5-1.ph4.x86_64 linux-5.10.206-1.ph4.x86_64 Linux-PAM-1.5.3-1.ph4.x86_64 logrotate-3.21.0-1.ph4.x86_64 lsof-4.95.0-1.ph4.x86_64 lsscsi-0.31-1.ph4.x86_64 lua-5.4.4-3.ph4.x86_64 lvm2-2.03.10-3.ph4.x86_64 lvm2-libs-2.03.10-3.ph4.x86_64 lz4-1.9.2-2.ph4.x86_64 lzo-2.10-1.ph4.x86_64 m4-1.4.18-3.ph4.x86_64 motd-0.1.3-7.ph4.noarch mpfr-4.1.0-2.ph4.x86_64 ncurses-6.2-6.ph4.x86_64 ncurses-compat-6.2-6.ph4.x86_64 ncurses-libs-6.2-6.ph4.x86_64 ncurses-terminfo-6.2-6.ph4.x86_64 nettle-3.7.3-1.ph4.x86_64 net-tools-1.60-13.ph4.x86_64 newt-0.52.21-1.ph4.x86_64 nghttp2-1.57.0-1.ph4.x86_64 npth-1.6-1.ph4.x86_64 nspr-4.32-1.ph4.x86_64 nss-3.72-4.ph4.x86_64 nss-libs-3.72-4.ph4.x86_64 ntp-4.2.8p16-1.ph4.x86_64 ntsysv-1.9-3.ph4.x86_64 numactl-2.0.14-3.ph4.x86_64 openldap-2.4.57-4.ph4.x86_64 open-sans-fonts-1.10-1.ph4.noarch openssh-8.9p1-6.ph4.x86_64 openssh-clients-8.9p1-6.ph4.x86_64 openssh-server-8.9p1-6.ph4.x86_64 openssl-3.0.9-8.ph4.x86_64 openssl-c_rehash-3.0.9-8.ph4.x86_64 openssl-fips-provider-3.0.8-1.ph4.x86_64 open-vm-tools-12.3.5-1.ph4.x86_64 open-vm-tools-gosc-12.3.5-1.ph4.x86_64 open-vm-tools-sdmp-12.3.5-1.ph4.x86_64 parted-3.3-3.ph4.x86_64 patch-2.7.6-5.ph4.x86_64 pciutils-3.7.0-2.ph4.x86_64 pcre-8.44-4.ph4.x86_64 pcre-libs-8.44-4.ph4.x86_64 photon-release-4.0-2.ph4.noarch photon-repos-4.0-3.ph4.noarch pinentry-1.1.0-1.ph4.x86_64 pixman-0.40.0-2.ph4.x86_64 pkg-config-0.29.2-5.ph4.x86_64 popt-1.16-5.ph4.x86_64 procps-ng-3.3.17-1.ph4.x86_64 psmisc-23.3-1.ph4.x86_64 python3-3.10.11-5.ph4.x86_64 python3-alabaster-0.7.12-2.ph4.noarch python3-asn1crypto-1.4.0-2.ph4.noarch python3-attrs-20.3.0-3.ph4.noarch python3-babel-2.9.1-2.ph4.noarch python3-backports_abc-0.5-5.ph4.noarch python3-bcrypt-3.2.0-2.ph4.x86_64 python3-certifi-2023.11.17-1.ph4.noarch python3-cffi-1.14.3-3.ph4.x86_64 python3-chardet-4.0.0-1.ph4.noarch python3-charset-normalizer-2.0.9-1.ph4.noarch python3-configobj-5.0.6-6.ph4.noarch python3-cryptography-41.0.7-1.ph4.x86_64 python3-curses-3.10.11-5.ph4.x86_64 python3-distro-1.5.0-2.ph4.noarch python3-docutils-0.16-3.ph4.noarch python3-ecdsa-0.16.0-2.ph4.noarch python3-idna-2.10-2.ph4.noarch python3-imagesize-1.2.0-3.ph4.noarch python3-jinja2-3.1.2-1.ph4.noarch python3-jmespath-0.10.0-4.ph4.noarch python3-jsonpatch-1.26-2.ph4.noarch python3-jsonpointer-2.0-3.ph4.noarch python3-jsonschema-3.2.0-2.ph4.noarch python3-libs-3.10.11-5.ph4.x86_64 python3-libxml2-2.9.12-12.ph4.x86_64 python3-lxml-4.9.1-1.ph4.x86_64 python3-M2Crypto-0.38.0-1.ph4.x86_64 python3-markupsafe-2.1.1-1.ph4.x86_64 python3-mock-4.0.3-2.ph4.noarch python3-msgpack-1.0.2-1.ph4.x86_64 python3-netaddr-0.8.0-3.ph4.noarch python3-netifaces-0.10.9-3.ph4.x86_64 python3-nocasedict-1.0.2-2.ph4.noarch python3-nocaselist-1.0.4-2.ph4.noarch python3-oauthlib-3.1.0-2.ph4.noarch python3-packaging-20.4-4.ph4.noarch python3-pam-1.8.4-2.ph4.noarch python3-paramiko-2.10.3-5.ph4.noarch python3-pbr-5.5.1-2.ph4.noarch python3-pip-23.0.1-1.ph4.noarch python3-ply-3.11-6.ph4.noarch python3-prettytable-0.7.2-8.ph4.noarch python3-psutil-5.7.3-3.ph4.x86_64 python3-pyasn1-0.4.8-2.ph4.noarch python3-pycparser-2.20-2.ph4.noarch python3-pycryptodome-3.12.0-3.ph4.x86_64 python3-pycryptodomex-3.9.9-3.ph4.x86_64 python3-Pygments-2.9.0-2.ph4.noarch python3-PyNaCl-1.4.0-2.ph4.x86_64 python3-pyOpenSSL-23.2.0-2.ph4.noarch python3-pyparsing-2.4.7-2.ph4.noarch python3-pyrsistent-0.17.3-3.ph4.x86_64 python3-pyserial-3.5-1.ph4.noarch python3-pytz-2020.4-3.ph4.noarch python3-pywbem-1.1.2-4.ph4.noarch python3-PyYAML-5.4.1-3.ph4.x86_64 python3-requests-2.26.0-2.ph4.noarch python3-resolvelib-0.5.5-1.ph4.noarch python3-setuptools-65.5.1-1.ph4.noarch python3-six-1.15.0-4.ph4.noarch python3-snowballstemmer-2.0.0-2.ph4.noarch python3-sphinx-5.1.1-1.ph4.noarch python3-sphinxcontrib-applehelp-1.0.2-3.ph4.noarch python3-sphinxcontrib-devhelp-1.0.2-3.ph4.noarch python3-sphinxcontrib-htmlhelp-2.0.0-1.ph4.noarch python3-sphinxcontrib-jsmath-1.0.1-3.ph4.noarch python3-sphinxcontrib-qthelp-1.0.3-3.ph4.noarch python3-sphinxcontrib-serializinghtml-1.1.5-1.ph4.noarch python3-tornado-6.0.4-3.ph4.x86_64 python3-typing-3.7.4.3-2.ph4.noarch python3-urllib3-1.25.11-5.ph4.noarch python3-xml-3.10.11-5.ph4.x86_64 python3-yamlloader-1.1.0-2.ph4.noarch python3-zmq-23.2.0-1.ph4.x86_64 readline-7.0-3.ph4.x86_64 rpcsvc-proto-1.4.2-1.ph4.x86_64 rpm-4.16.1.3-18.ph4.x86_64 rpm-libs-4.16.1.3-18.ph4.x86_64 rpm-plugin-systemd-inhibit-4.16.1.3-18.ph4.x86_64 rsync-3.2.4-1.ph4.x86_64 rsyslog-8.2306.0-3.ph4.x86_64 salt3-3005.4-2.ph4.noarch salt3-minion-3005.4-2.ph4.noarch sed-4.8-3.ph4.x86_64 sg3_utils-1.44-2.ph4.x86_64 shadow-4.13-2.ph4.x86_64 shadow-libs-4.13-2.ph4.x86_64 shadow-tools-4.13-2.ph4.x86_64 shim-signed-15.4-1.ph4.x86_64 slang-2.3.2-1.ph4.x86_64 sqlite-libs-3.38.5-4.ph4.x86_64 sshfs-3.7.0-4.ph4.x86_64 sshpass-1.10-1.ph4.x86_64 stig-hardening-1.5-2.ph4.noarch sudo-1.9.15p5-1.ph4.x86_64 sysstat-12.7.2-1.ph4.x86_64 systemd-247.13-12.ph4.x86_64 systemd-libs-247.13-12.ph4.x86_64 systemd-pam-247.13-12.ph4.x86_64 systemd-rpm-macros-247.13-12.ph4.noarch systemd-udev-247.13-12.ph4.x86_64 tar-1.34-5.ph4.x86_64 tcp_wrappers-7.6-7.ph4.x86_64 tdnf-3.3.9-3.ph4.x86_64 tdnf-cli-libs-3.3.9-3.ph4.x86_64 tomcat-template-8.5.97.0-1.vmw.22955628.x86_64 tzdata-2022g-1.ph4.noarch unzip-6.0-16.ph4.x86_64 util-linux-2.37.4-1.ph4.x86_64 util-linux-libs-2.37.4-1.ph4.x86_64 vim-9.0.2121-1.ph4.x86_64 vmware-casa-1.0.0-23251567.x86_64 vmware-jre-11.0.20-8.x86_64 VMware-Log-Insight-Agent-8.16.0-23229978.noarch VMware-Postgres-14.10.0-22941784.x86_64 VMware-Postgres-client-jdbc-14.10.0-22941784.noarch VMware-Postgres-contrib-14.10.0-22941784.x86_64 VMware-Postgres-extras-14.10.0-22941784.x86_64 VMware-Postgres-libs-14.10.0-22941784.x86_64 VMware-Postgres-pg_rewind-14.10.0-22941784.x86_64 VMware-Postgres-pg_top-14.10.0-22941784.x86_64 VMware-Postgres-plperl-14.10.0-22941784.x86_64 VMware-Postgres-server-14.10.0-22941784.x86_64 vmware-vcops-8.16.0-23251572.x86_64 vmware-vcopssuite-utilities-1.0.0-23251573.x86_64 vmware-vcops-web-admin-8.16.0-23251572.x86_64 vrops-init-8.16.0.0-23251568.noarch wget-1.21.3-1.ph4.x86_64 which-2.21-6.ph4.x86_64 xmlsec1-1.2.30-6.ph4.x86_64 xxhash-0.8.1-1.ph4.x86_64 xxhash-libs-0.8.1-1.ph4.x86_64 xz-5.2.5-2.ph4.x86_64 xz-libs-5.2.5-2.ph4.x86_64 zchunk-libs-1.1.7-3.ph4.x86_64 zip-3.0-3.ph4.x86_64 zlib-1.2.11-6.ph4.x86_64 zstd-1.5.2-2.ph4.x86_64 zstd-libs-1.5.2-2.ph4.x86_64

Aria Operations 8.16.1

admin@vrops02 [ ~ ]$ rpm -qa | sort ansible-2.14.12-2.ph4.noarch ansible-community-general-5.6.0-3.ph4.noarch ansible-posix-1.4.0-3.ph4.noarch apr-1.7.2-1.ph4.x86_64 apr-util-1.6.3-1.ph4.x86_64 attr-2.4.48-2.ph4.x86_64 audit-2.8.5-30.ph4.x86_64 autogen-libopts-5.18.16-4.ph4.x86_64 bash-5.0-4.ph4.x86_64 bc-1.07.1-4.ph4.x86_64 bindutils-9.16.48-1.ph4.x86_64 bridge-utils-1.6-1.ph4.x86_64 btrfs-progs-5.7-3.ph4.x86_64 bzip2-1.0.8-4.ph4.x86_64 bzip2-libs-1.0.8-4.ph4.x86_64 ca-certificates-20201001-4.ph4.x86_64 ca-certificates-pki-20201001-4.ph4.x86_64 cairo-1.17.2-6.ph4.x86_64 c-ares-1.19.1-1.ph4.x86_64 chkconfig-1.9-3.ph4.x86_64 chromium-119.0.6045.176-2.ph4.x86_64 cifs-utils-6.13-2.ph4.x86_64 cloud-init-23.4-4.ph4.noarch cmocka-1.1.5-3.ph4.x86_64 coreutils-selinux-9.1-2.ph4.x86_64 cpio-2.13-9.ph4.x86_64 cracklib-2.9.7-4.ph4.x86_64 cracklib-dicts-2.9.7-4.ph4.x86_64 cronie-1.5.5-1.ph4.x86_64 curl-8.1.2-7.ph4.x86_64 curl-libs-8.1.2-7.ph4.x86_64 cyrus-sasl-2.1.27-7.ph4.x86_64 dbus-1.13.18-3.ph4.x86_64 device-mapper-2.03.10-3.ph4.x86_64 device-mapper-event-2.03.10-3.ph4.x86_64 device-mapper-event-libs-2.03.10-3.ph4.x86_64 device-mapper-libs-2.03.10-3.ph4.x86_64 dhcp-client-4.4.2-6.ph4.x86_64 dhcp-libs-4.4.2-6.ph4.x86_64 distrib-compat-0.1-2.ph4.x86_64 dracut-050-13.ph4.x86_64 drpm-0.5.0-6.ph4.x86_64 e2fsprogs-1.46.5-2.ph4.x86_64 e2fsprogs-libs-1.46.5-2.ph4.x86_64 elfutils-0.181-7.ph4.x86_64 elfutils-libelf-0.181-7.ph4.x86_64 ethtool-5.10-1.ph4.x86_64 expat-2.2.9-11.ph4.x86_64 expat-libs-2.2.9-11.ph4.x86_64 file-5.39-2.ph4.x86_64 file-libs-5.39-2.ph4.x86_64 filesystem-1.1-4.ph4.x86_64 findutils-4.7.0-1.ph4.x86_64 finger-0.17-3.ph4.x86_64 flex-2.6.4-3.ph4.x86_64 fontconfig-2.13.1-5.ph4.x86_64 fping-5.0-1.ph4.x86_64 freetype2-2.13.0-1.ph4.x86_64 fuse-2.9.9-1.ph4.x86_64 fuse3-3.9.4-4.ph4.x86_64 gawk-5.1.1-1.ph4.x86_64 gc-8.0.4-2.ph4.x86_64 gdbm-1.19-1.ph4.x86_64 gettext-0.21-3.ph4.x86_64 glib-2.68.4-1.ph4.x86_64 glibc-2.32-15.ph4.x86_64 glibc-i18n-2.32-15.ph4.x86_64 glibc-iconv-2.32-15.ph4.x86_64 glibc-lang-2.32-15.ph4.x86_64 gmp-6.2.0-1.ph4.x86_64 gnupg-2.2.23-4.ph4.x86_64 gnutls-3.7.10-2.ph4.x86_64 gpg-pubkey-66fd4949-4803fe57 gpg-pubkey-8a6a826d-596882ca grep-3.4-2.ph4.x86_64 grub2-2.06-12.ph4.x86_64 grub2-theme-4.0-2.ph4.noarch guile-2.0.13-4.ph4.x86_64 gzip-1.12-2.ph4.x86_64 haveged-1.9.18-1.ph4.x86_64 httpd-2.4.58-2.ph4.x86_64 httpd-mod_jk-1.2.48-9.ph4.x86_64 iana-etc-2.30-2.ph4.noarch initramfs-2.0-7.ph4.x86_64 initscripts-10.04-2.ph4.x86_64 inotify-tools-3.13-2.ph4.x86_64 ipcalc-0.4.1-1.ph4.x86_64 iproute2-5.10.0-4.ph4.x86_64 iptables-1.8.9-3.ph4.x86_64 iputils-20200821-3.ph4.x86_64 irqbalance-1.7.0-4.ph4.x86_64 jansson-2.13.1-1.ph4.x86_64 kbd-2.3.0-2.ph4.x86_64 kmod-27-1.ph4.x86_64 krb5-1.17-10.ph4.x86_64 less-551-2.ph4.x86_64 libacl-2.2.53-2.ph4.x86_64 libaio-0.3.110-3.ph4.x86_64 libarchive-3.4.3-10.ph4.x86_64 libassuan-2.5.3-2.ph4.x86_64 libatomic_ops-7.6.10-2.ph4.x86_64 libcap-2.43-3.ph4.x86_64 libcap-ng-0.8-2.ph4.x86_64 libedit-3.1.20210910-2.ph4.x86_64 libestr-0.1.11-2.ph4.x86_64 libevent-2.1.12-1.ph4.x86_64 libfastjson-0.99.8-1.ph4.x86_64 libffi-3.3-1.ph4.x86_64 libgcc-10.5.0-1.ph4.x86_64 libgcrypt-1.9.4-2.ph4.x86_64 libgomp-10.5.0-1.ph4.x86_64 libgpg-error-1.39-1.ph4.x86_64 libksba-1.4.0-4.ph4.x86_64 liblogging-1.0.6-2.ph4.x86_64 libltdl-2.4.6-3.ph4.x86_64 libmicrohttpd-0.9.76-2.ph4.x86_64 libmnl-1.0.4-4.ph4.x86_64 libmspack-0.10.1alpha-3.ph4.x86_64 libnftnl-1.2.1-1.ph4.x86_64 libnsl-1.3.0-2.ph4.x86_64 libnuma-2.0.14-3.ph4.x86_64 libpcap-1.10.0-1.ph4.x86_64 libpng-1.6.37-2.ph4.x86_64 libpwquality-1.4.2-3.ph4.x86_64 librelp-1.8.0-5.ph4.x86_64 libseccomp-2.5.0-3.ph4.x86_64 libselinux-3.3-1.ph4.x86_64 libsepol-3.3-1.ph4.x86_64 libsolv-0.7.19-5.ph4.x86_64 libssh2-1.11.0-1.ph4.x86_64 libstdc++-10.5.0-1.ph4.x86_64 libtasn1-4.14-2.ph4.x86_64 libtirpc-1.2.6-4.ph4.x86_64 libtool-2.4.6-3.ph4.x86_64 libunistring-0.9.10-2.ph4.x86_64 libuv-1.45.0-1.ph4.x86_64 libX11-1.8.5-2.ph4.x86_64 libXau-1.0.9-1.ph4.x86_64 libxcb-1.15-1.ph4.x86_64 libXdmcp-1.1.3-1.ph4.x86_64 libXext-1.3.4-3.ph4.x86_64 libxml2-2.9.12-12.ph4.x86_64 libxml2-devel-2.9.12-12.ph4.x86_64 libxslt-1.1.34-7.ph4.x86_64 libyaml-0.2.5-1.ph4.x86_64 linux-5.10.209-1.ph4.x86_64 Linux-PAM-1.5.3-2.ph4.x86_64 logrotate-3.21.0-1.ph4.x86_64 lsof-4.95.0-1.ph4.x86_64 lsscsi-0.31-1.ph4.x86_64 lua-5.4.4-3.ph4.x86_64 lvm2-2.03.10-3.ph4.x86_64 lvm2-libs-2.03.10-3.ph4.x86_64 lz4-1.9.2-2.ph4.x86_64 lzo-2.10-1.ph4.x86_64 m4-1.4.18-3.ph4.x86_64 motd-0.1.3-7.ph4.noarch mpfr-4.1.0-2.ph4.x86_64 ncurses-6.2-6.ph4.x86_64 ncurses-compat-6.2-6.ph4.x86_64 ncurses-libs-6.2-6.ph4.x86_64 ncurses-terminfo-6.2-6.ph4.x86_64 nettle-3.7.3-1.ph4.x86_64 net-tools-1.60-13.ph4.x86_64 newt-0.52.21-1.ph4.x86_64 nghttp2-1.57.0-1.ph4.x86_64 npth-1.6-1.ph4.x86_64 nspr-4.32-1.ph4.x86_64 nss-3.72-4.ph4.x86_64 nss-libs-3.72-4.ph4.x86_64 ntp-4.2.8p16-1.ph4.x86_64 ntsysv-1.9-3.ph4.x86_64 numactl-2.0.14-3.ph4.x86_64 openldap-2.4.57-4.ph4.x86_64 open-sans-fonts-1.10-1.ph4.noarch openssh-8.9p1-6.ph4.x86_64 openssh-clients-8.9p1-6.ph4.x86_64 openssh-server-8.9p1-6.ph4.x86_64 openssl-3.0.9-9.ph4.x86_64 openssl-c_rehash-3.0.9-9.ph4.x86_64 openssl-fips-provider-3.0.8-1.ph4.x86_64 open-vm-tools-12.3.5-1.ph4.x86_64 open-vm-tools-gosc-12.3.5-1.ph4.x86_64 open-vm-tools-sdmp-12.3.5-1.ph4.x86_64 parted-3.3-3.ph4.x86_64 patch-2.7.6-6.ph4.x86_64 pciutils-3.7.0-2.ph4.x86_64 pcre-8.44-4.ph4.x86_64 pcre-libs-8.44-4.ph4.x86_64 photon-release-4.0-2.ph4.noarch photon-repos-4.0-3.ph4.noarch pinentry-1.1.0-1.ph4.x86_64 pixman-0.40.0-2.ph4.x86_64 pkg-config-0.29.2-5.ph4.x86_64 popt-1.16-5.ph4.x86_64 procps-ng-3.3.17-2.ph4.x86_64 psmisc-23.3-1.ph4.x86_64 python3-3.10.11-6.ph4.x86_64 python3-alabaster-0.7.12-2.ph4.noarch python3-asn1crypto-1.4.0-2.ph4.noarch python3-attrs-20.3.0-3.ph4.noarch python3-babel-2.9.1-2.ph4.noarch python3-backports_abc-0.5-5.ph4.noarch python3-bcrypt-3.2.0-2.ph4.x86_64 python3-certifi-2023.11.17-1.ph4.noarch python3-cffi-1.14.3-3.ph4.x86_64 python3-chardet-4.0.0-1.ph4.noarch python3-charset-normalizer-2.0.9-1.ph4.noarch python3-configobj-5.0.6-6.ph4.noarch python3-cryptography-41.0.7-1.ph4.x86_64 python3-curses-3.10.11-6.ph4.x86_64 python3-distro-1.5.0-2.ph4.noarch python3-docutils-0.16-3.ph4.noarch python3-ecdsa-0.16.0-2.ph4.noarch python3-idna-2.10-2.ph4.noarch python3-imagesize-1.2.0-3.ph4.noarch python3-jinja2-3.1.2-1.ph4.noarch python3-jmespath-0.10.0-4.ph4.noarch python3-jsonpatch-1.26-2.ph4.noarch python3-jsonpointer-2.0-3.ph4.noarch python3-jsonschema-3.2.0-2.ph4.noarch python3-libs-3.10.11-6.ph4.x86_64 python3-libxml2-2.9.12-12.ph4.x86_64 python3-lxml-4.9.1-1.ph4.x86_64 python3-M2Crypto-0.38.0-1.ph4.x86_64 python3-markupsafe-2.1.1-1.ph4.x86_64 python3-mock-4.0.3-2.ph4.noarch python3-msgpack-1.0.2-1.ph4.x86_64 python3-netaddr-0.8.0-3.ph4.noarch python3-netifaces-0.10.9-3.ph4.x86_64 python3-nocasedict-1.0.2-2.ph4.noarch python3-nocaselist-1.0.4-2.ph4.noarch python3-oauthlib-3.1.0-2.ph4.noarch python3-packaging-20.4-4.ph4.noarch python3-pam-1.8.4-2.ph4.noarch python3-paramiko-2.10.3-5.ph4.noarch python3-pbr-5.5.1-2.ph4.noarch python3-pip-23.3.2-1.ph4.noarch python3-ply-3.11-6.ph4.noarch python3-prettytable-0.7.2-8.ph4.noarch python3-psutil-5.7.3-3.ph4.x86_64 python3-pyasn1-0.4.8-2.ph4.noarch python3-pycparser-2.20-2.ph4.noarch python3-pycryptodome-3.12.0-3.ph4.x86_64 python3-pycryptodomex-3.9.9-3.ph4.x86_64 python3-Pygments-2.9.0-2.ph4.noarch python3-PyNaCl-1.4.0-2.ph4.x86_64 python3-pyOpenSSL-23.2.0-2.ph4.noarch python3-pyparsing-2.4.7-2.ph4.noarch python3-pyrsistent-0.17.3-3.ph4.x86_64 python3-pyserial-3.5-1.ph4.noarch python3-pytz-2020.4-3.ph4.noarch python3-pywbem-1.1.2-4.ph4.noarch python3-PyYAML-5.4.1-3.ph4.x86_64 python3-requests-2.26.0-2.ph4.noarch python3-resolvelib-0.5.5-1.ph4.noarch python3-setuptools-65.5.1-1.ph4.noarch python3-six-1.15.0-4.ph4.noarch python3-snowballstemmer-2.0.0-2.ph4.noarch python3-sphinx-5.1.1-1.ph4.noarch python3-sphinxcontrib-applehelp-1.0.2-3.ph4.noarch python3-sphinxcontrib-devhelp-1.0.2-3.ph4.noarch python3-sphinxcontrib-htmlhelp-2.0.0-1.ph4.noarch python3-sphinxcontrib-jsmath-1.0.1-3.ph4.noarch python3-sphinxcontrib-qthelp-1.0.3-3.ph4.noarch python3-sphinxcontrib-serializinghtml-1.1.5-1.ph4.noarch python3-tornado-6.0.4-3.ph4.x86_64 python3-typing-3.7.4.3-2.ph4.noarch python3-urllib3-1.25.11-5.ph4.noarch python3-xml-3.10.11-6.ph4.x86_64 python3-yamlloader-1.1.0-2.ph4.noarch python3-zmq-23.2.0-1.ph4.x86_64 readline-7.0-3.ph4.x86_64 rpcsvc-proto-1.4.2-1.ph4.x86_64 rpm-4.16.1.3-18.ph4.x86_64 rpm-libs-4.16.1.3-18.ph4.x86_64 rpm-plugin-systemd-inhibit-4.16.1.3-18.ph4.x86_64 rsync-3.2.4-1.ph4.x86_64 rsyslog-8.2306.0-3.ph4.x86_64 salt3-3005.5-1.ph4.noarch salt3-minion-3005.5-1.ph4.noarch sed-4.8-3.ph4.x86_64 sg3_utils-1.44-2.ph4.x86_64 shadow-4.13-2.ph4.x86_64 shadow-libs-4.13-2.ph4.x86_64 shadow-tools-4.13-2.ph4.x86_64 slang-2.3.2-1.ph4.x86_64 sqlite-libs-3.38.5-4.ph4.x86_64 sshfs-3.7.0-4.ph4.x86_64 sshpass-1.10-1.ph4.x86_64 stig-hardening-1.5-2.ph4.noarch sudo-1.9.15p5-1.ph4.x86_64 sysstat-12.7.2-1.ph4.x86_64 systemd-247.13-12.ph4.x86_64 systemd-libs-247.13-12.ph4.x86_64 systemd-pam-247.13-12.ph4.x86_64 systemd-rpm-macros-247.13-12.ph4.noarch systemd-udev-247.13-12.ph4.x86_64 tar-1.34-5.ph4.x86_64 tcp_wrappers-7.6-7.ph4.x86_64 tdnf-3.3.9-3.ph4.x86_64 tdnf-cli-libs-3.3.9-3.ph4.x86_64 tomcat-template-8.5.97.0-1.vmw.22955628.x86_64 tzdata-2022g-1.ph4.noarch unzip-6.0-16.ph4.x86_64 util-linux-2.37.4-1.ph4.x86_64 util-linux-libs-2.37.4-1.ph4.x86_64 vim-9.0.2121-1.ph4.x86_64 vmware-casa-1.0.0-23362242.x86_64 vmware-jre-11.0.22-12.x86_64 VMware-Log-Insight-Agent-8.16.0-23229978.noarch VMware-Postgres-14.10.0-22941784.x86_64 VMware-Postgres-client-jdbc-14.10.0-22941784.noarch VMware-Postgres-contrib-14.10.0-22941784.x86_64 VMware-Postgres-extras-14.10.0-22941784.x86_64 VMware-Postgres-libs-14.10.0-22941784.x86_64 VMware-Postgres-pg_rewind-14.10.0-22941784.x86_64 VMware-Postgres-pg_top-14.10.0-22941784.x86_64 VMware-Postgres-plperl-14.10.0-22941784.x86_64 VMware-Postgres-server-14.10.0-22941784.x86_64 vmware-vcops-8.16.1-23362245.x86_64 vmware-vcopssuite-utilities-1.0.0-23362248.x86_64 vmware-vcops-web-admin-8.16.1-23362245.x86_64 vrops-init-8.16.1.0-23362243.noarch wget-1.21.3-1.ph4.x86_64 which-2.21-6.ph4.x86_64 xmlsec1-1.2.30-6.ph4.x86_64 xxhash-0.8.1-1.ph4.x86_64 xxhash-libs-0.8.1-1.ph4.x86_64 xz-5.2.5-2.ph4.x86_64 xz-libs-5.2.5-2.ph4.x86_64 zchunk-libs-1.1.7-3.ph4.x86_64 zip-3.0-3.ph4.x86_64 zlib-1.2.11-6.ph4.x86_64 zstd-1.5.2-2.ph4.x86_64 zstd-libs-1.5.2-2.ph4.x86_64

ちなみに diff ってみる

$ diff 8.16.0.txt 8.16.1.txt 1c1 < ansible-2.14.12-1.ph4.noarch --- > ansible-2.14.12-2.ph4.noarch 11c11 < bindutils-9.16.42-4.ph4.x86_64 --- > bindutils-9.16.48-1.ph4.x86_64 23c23 < cloud-init-23.4-3.ph4.noarch --- > cloud-init-23.4-4.ph4.noarch 66,69c66,69 < glibc-2.32-14.ph4.x86_64 < glibc-i18n-2.32-14.ph4.x86_64 < glibc-iconv-2.32-14.ph4.x86_64 < glibc-lang-2.32-14.ph4.x86_64 --- > glibc-2.32-15.ph4.x86_64 > glibc-i18n-2.32-15.ph4.x86_64 > glibc-iconv-2.32-15.ph4.x86_64 > glibc-lang-2.32-15.ph4.x86_64 72c72 < gnutls-3.7.10-1.ph4.x86_64 --- > gnutls-3.7.10-2.ph4.x86_64 77d76 < grub2-efi-image-2.06-12.ph4.x86_64 81c80 < haveged-1.9.13-2.ph4.x86_64 --- > haveged-1.9.18-1.ph4.x86_64 110c109 < libgcc-10.2.0-2.ph4.x86_64 --- > libgcc-10.5.0-1.ph4.x86_64 112c111 < libgomp-10.2.0-2.ph4.x86_64 --- > libgomp-10.5.0-1.ph4.x86_64 132c131 < libstdc++-10.2.0-2.ph4.x86_64 --- > libstdc++-10.5.0-1.ph4.x86_64 147,148c146,147 < linux-5.10.206-1.ph4.x86_64 < Linux-PAM-1.5.3-1.ph4.x86_64 --- > linux-5.10.209-1.ph4.x86_64 > Linux-PAM-1.5.3-2.ph4.x86_64 180,181c179,180 < openssl-3.0.9-8.ph4.x86_64 < openssl-c_rehash-3.0.9-8.ph4.x86_64 --- > openssl-3.0.9-9.ph4.x86_64 > openssl-c_rehash-3.0.9-9.ph4.x86_64 187c186 < patch-2.7.6-5.ph4.x86_64 --- > patch-2.7.6-6.ph4.x86_64 197c196 < procps-ng-3.3.17-1.ph4.x86_64 --- > procps-ng-3.3.17-2.ph4.x86_64 199c198 < python3-3.10.11-5.ph4.x86_64 --- > python3-3.10.11-6.ph4.x86_64 212c211 < python3-curses-3.10.11-5.ph4.x86_64 --- > python3-curses-3.10.11-6.ph4.x86_64 223c222 < python3-libs-3.10.11-5.ph4.x86_64 --- > python3-libs-3.10.11-6.ph4.x86_64 239c238 < python3-pip-23.0.1-1.ph4.noarch --- > python3-pip-23.3.2-1.ph4.noarch 271c270 < python3-xml-3.10.11-5.ph4.x86_64 --- > python3-xml-3.10.11-6.ph4.x86_64 281,282c280,281 < salt3-3005.4-2.ph4.noarch < salt3-minion-3005.4-2.ph4.noarch --- > salt3-3005.5-1.ph4.noarch > salt3-minion-3005.5-1.ph4.noarch 288d286 < shim-signed-15.4-1.ph4.x86_64 311,312c309,310 < vmware-casa-1.0.0-23251567.x86_64 < vmware-jre-11.0.20-8.x86_64 --- > vmware-casa-1.0.0-23362242.x86_64 > vmware-jre-11.0.22-12.x86_64 323,326c321,324 < vmware-vcops-8.16.0-23251572.x86_64 < vmware-vcopssuite-utilities-1.0.0-23251573.x86_64 < vmware-vcops-web-admin-8.16.0-23251572.x86_64 < vrops-init-8.16.0.0-23251568.noarch --- > vmware-vcops-8.16.1-23362245.x86_64 > vmware-vcopssuite-utilities-1.0.0-23362248.x86_64 > vmware-vcops-web-admin-8.16.1-23362245.x86_64 > vrops-init-8.16.1.0-23362243.noarch

中に ansible がいたり。OVA デプロイ後、初回起動のインストール時に動くのかなぁ。

そして、vcops という古の名称が…

Hot Fix 適用

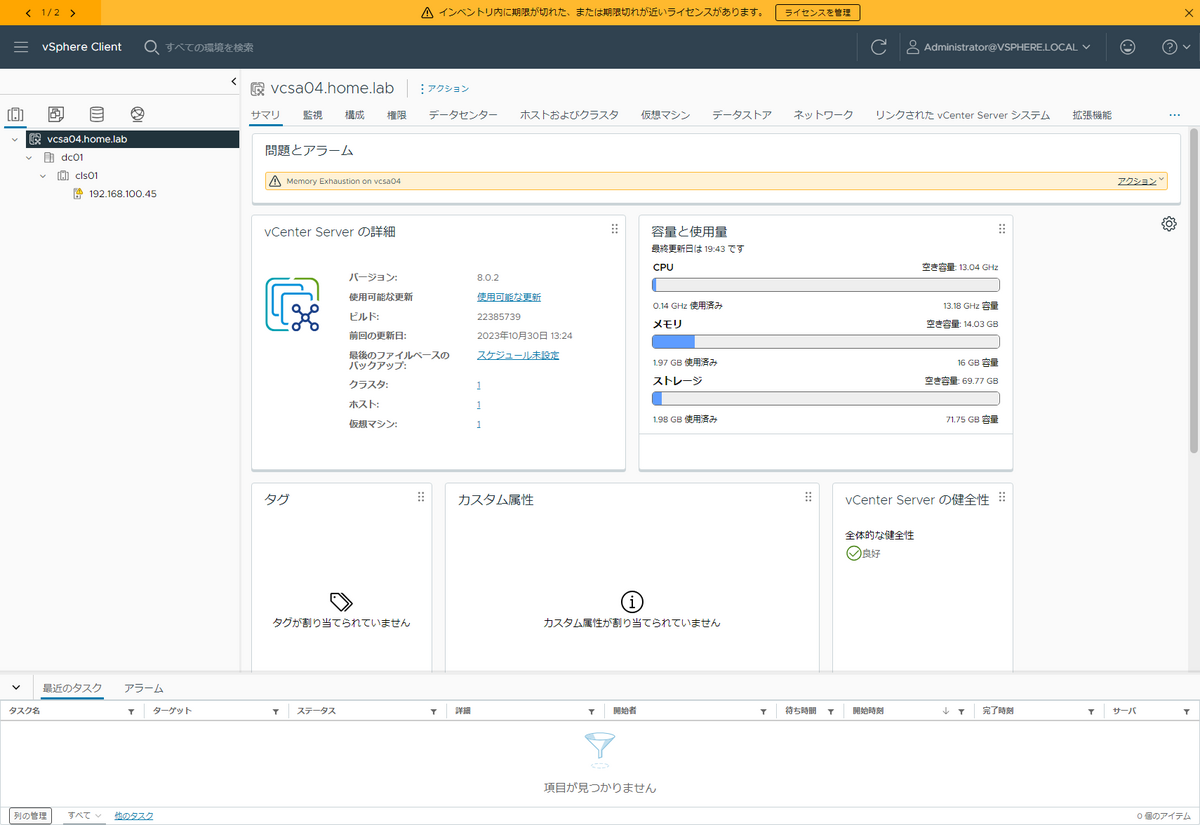

Hot Fix の入手は Customer Connect の製品パッチから。

![]() 容量デカい…

容量デカい…

Hot Fix の適用は admin 側の WebUI からさきほどの pak ファイルをアップロードしてインストールします。

結構時間がかかる(40分強くらいかかった)

結構時間がかかる(40分強くらいかかった)

適用後

旧 8.16.環境。しれっと 8.16.1 になっとる…

旧 8.16.1 環境。ビルド番号だけ上がってますね。

もう答えは出ているようなものだが、一応パッケージ比較。

もう答えは出ているようなものだが、一応パッケージ比較。

旧 8.16

admin@vrops01 [ ~ ]$ rpm -qa | sort ansible-2.14.12-2.ph4.noarch ansible-community-general-5.6.0-3.ph4.noarch ansible-posix-1.4.0-3.ph4.noarch apr-1.7.2-1.ph4.x86_64 apr-util-1.6.3-1.ph4.x86_64 attr-2.4.48-2.ph4.x86_64 audit-2.8.5-30.ph4.x86_64 autogen-libopts-5.18.16-4.ph4.x86_64 bash-5.0-4.ph4.x86_64 bc-1.07.1-4.ph4.x86_64 bindutils-9.16.48-1.ph4.x86_64 bridge-utils-1.6-1.ph4.x86_64 btrfs-progs-5.7-3.ph4.x86_64 bzip2-1.0.8-4.ph4.x86_64 bzip2-libs-1.0.8-4.ph4.x86_64 ca-certificates-20201001-4.ph4.x86_64 ca-certificates-pki-20201001-4.ph4.x86_64 cairo-1.17.2-6.ph4.x86_64 c-ares-1.19.1-2.ph4.x86_64 chkconfig-1.9-3.ph4.x86_64 chromium-123.0.6283.1-1.ph4.x86_64 cifs-utils-6.13-2.ph4.x86_64 cloud-init-23.4-4.ph4.noarch cmocka-1.1.5-3.ph4.x86_64 coreutils-selinux-9.1-2.ph4.x86_64 cpio-2.13-9.ph4.x86_64 cracklib-2.9.7-4.ph4.x86_64 cracklib-dicts-2.9.7-4.ph4.x86_64 cronie-1.5.5-1.ph4.x86_64 curl-8.1.2-7.ph4.x86_64 curl-libs-8.1.2-7.ph4.x86_64 cyrus-sasl-2.1.27-7.ph4.x86_64 dbus-1.13.18-3.ph4.x86_64 device-mapper-2.03.10-3.ph4.x86_64 device-mapper-event-2.03.10-3.ph4.x86_64 device-mapper-event-libs-2.03.10-3.ph4.x86_64 device-mapper-libs-2.03.10-3.ph4.x86_64 dhcp-client-4.4.2-6.ph4.x86_64 dhcp-libs-4.4.2-6.ph4.x86_64 distrib-compat-0.1-2.ph4.x86_64 dracut-050-13.ph4.x86_64 drpm-0.5.0-6.ph4.x86_64 e2fsprogs-1.46.5-2.ph4.x86_64 e2fsprogs-libs-1.46.5-2.ph4.x86_64 elfutils-0.181-7.ph4.x86_64 elfutils-libelf-0.181-7.ph4.x86_64 ethtool-5.10-1.ph4.x86_64 expat-2.2.9-11.ph4.x86_64 expat-libs-2.2.9-11.ph4.x86_64 file-5.39-2.ph4.x86_64 file-libs-5.39-2.ph4.x86_64 filesystem-1.1-4.ph4.x86_64 findutils-4.7.0-1.ph4.x86_64 finger-0.17-3.ph4.x86_64 flex-2.6.4-3.ph4.x86_64 fontconfig-2.13.1-5.ph4.x86_64 fping-5.0-1.ph4.x86_64 freetype2-2.13.0-1.ph4.x86_64 fuse-2.9.9-1.ph4.x86_64 fuse3-3.9.4-4.ph4.x86_64 gawk-5.1.1-1.ph4.x86_64 gc-8.0.4-2.ph4.x86_64 gdbm-1.19-1.ph4.x86_64 gettext-0.21-3.ph4.x86_64 glib-2.68.4-1.ph4.x86_64 glibc-2.32-15.ph4.x86_64 glibc-i18n-2.32-15.ph4.x86_64 glibc-iconv-2.32-15.ph4.x86_64 glibc-lang-2.32-15.ph4.x86_64 gmp-6.2.0-1.ph4.x86_64 gnupg-2.2.23-4.ph4.x86_64 gnutls-3.7.10-2.ph4.x86_64 gpg-pubkey-66fd4949-4803fe57 gpg-pubkey-8a6a826d-596882ca grep-3.4-2.ph4.x86_64 grub2-2.06-12.ph4.x86_64 grub2-theme-4.0-2.ph4.noarch guile-2.0.13-4.ph4.x86_64 gzip-1.12-2.ph4.x86_64 haveged-1.9.18-1.ph4.x86_64 httpd-2.4.58-2.ph4.x86_64 httpd-mod_jk-1.2.48-9.ph4.x86_64 iana-etc-2.30-2.ph4.noarch initramfs-2.0-7.ph4.x86_64 initscripts-10.04-2.ph4.x86_64 inotify-tools-3.13-2.ph4.x86_64 ipcalc-0.4.1-1.ph4.x86_64 iproute2-5.10.0-4.ph4.x86_64 iptables-1.8.9-3.ph4.x86_64 iputils-20200821-3.ph4.x86_64 irqbalance-1.7.0-4.ph4.x86_64 jansson-2.13.1-1.ph4.x86_64 kbd-2.3.0-2.ph4.x86_64 kmod-27-1.ph4.x86_64 krb5-1.17-10.ph4.x86_64 less-551-2.ph4.x86_64 libacl-2.2.53-2.ph4.x86_64 libaio-0.3.110-3.ph4.x86_64 libarchive-3.4.3-10.ph4.x86_64 libassuan-2.5.3-2.ph4.x86_64 libatomic_ops-7.6.10-2.ph4.x86_64 libcap-2.43-3.ph4.x86_64 libcap-ng-0.8-2.ph4.x86_64 libedit-3.1.20210910-2.ph4.x86_64 libestr-0.1.11-2.ph4.x86_64 libevent-2.1.12-1.ph4.x86_64 libfastjson-0.99.8-1.ph4.x86_64 libffi-3.3-1.ph4.x86_64 libgcc-10.5.0-1.ph4.x86_64 libgcrypt-1.9.4-2.ph4.x86_64 libgomp-10.5.0-1.ph4.x86_64 libgpg-error-1.39-1.ph4.x86_64 libksba-1.4.0-4.ph4.x86_64 liblogging-1.0.6-2.ph4.x86_64 libltdl-2.4.6-3.ph4.x86_64 libmicrohttpd-0.9.76-2.ph4.x86_64 libmnl-1.0.4-4.ph4.x86_64 libmspack-0.10.1alpha-3.ph4.x86_64 libnftnl-1.2.1-1.ph4.x86_64 libnsl-1.3.0-2.ph4.x86_64 libnuma-2.0.14-3.ph4.x86_64 libpcap-1.10.0-1.ph4.x86_64 libpng-1.6.37-2.ph4.x86_64 libpwquality-1.4.2-3.ph4.x86_64 librelp-1.8.0-5.ph4.x86_64 libseccomp-2.5.0-3.ph4.x86_64 libselinux-3.3-1.ph4.x86_64 libsepol-3.3-1.ph4.x86_64 libsolv-0.7.19-5.ph4.x86_64 libssh2-1.11.0-1.ph4.x86_64 libstdc++-10.5.0-1.ph4.x86_64 libtasn1-4.14-2.ph4.x86_64 libtirpc-1.2.6-4.ph4.x86_64 libtool-2.4.6-3.ph4.x86_64 libunistring-0.9.10-2.ph4.x86_64 libuv-1.45.0-2.ph4.x86_64 libX11-1.8.5-2.ph4.x86_64 libXau-1.0.9-1.ph4.x86_64 libxcb-1.15-1.ph4.x86_64 libXdmcp-1.1.3-1.ph4.x86_64 libXext-1.3.4-3.ph4.x86_64 libxml2-2.9.12-13.ph4.x86_64 libxml2-devel-2.9.12-13.ph4.x86_64 libxslt-1.1.34-7.ph4.x86_64 libyaml-0.2.5-1.ph4.x86_64 linux-5.10.210-2.ph4.x86_64 Linux-PAM-1.5.3-2.ph4.x86_64 logrotate-3.21.0-1.ph4.x86_64 lsof-4.95.0-1.ph4.x86_64 lsscsi-0.31-1.ph4.x86_64 lua-5.4.4-3.ph4.x86_64 lvm2-2.03.10-3.ph4.x86_64 lvm2-libs-2.03.10-3.ph4.x86_64 lz4-1.9.2-2.ph4.x86_64 lzo-2.10-1.ph4.x86_64 m4-1.4.18-3.ph4.x86_64 motd-0.1.3-7.ph4.noarch mpfr-4.1.0-2.ph4.x86_64 ncurses-6.2-6.ph4.x86_64 ncurses-compat-6.2-6.ph4.x86_64 ncurses-libs-6.2-6.ph4.x86_64 ncurses-terminfo-6.2-6.ph4.x86_64 nettle-3.7.3-1.ph4.x86_64 net-tools-1.60-13.ph4.x86_64 newt-0.52.21-1.ph4.x86_64 nghttp2-1.57.0-1.ph4.x86_64 npth-1.6-1.ph4.x86_64 nspr-4.32-1.ph4.x86_64 nss-3.72-4.ph4.x86_64 nss-libs-3.72-4.ph4.x86_64 ntp-4.2.8p16-1.ph4.x86_64 ntsysv-1.9-3.ph4.x86_64 numactl-2.0.14-3.ph4.x86_64 openldap-2.4.57-4.ph4.x86_64 open-sans-fonts-1.10-1.ph4.noarch openssh-8.9p1-6.ph4.x86_64 openssh-clients-8.9p1-6.ph4.x86_64 openssh-server-8.9p1-6.ph4.x86_64 openssl-3.0.13-2.ph4.x86_64 openssl-c_rehash-3.0.13-2.ph4.x86_64 openssl-fips-provider-3.0.8-1.ph4.x86_64 open-vm-tools-12.3.5-1.ph4.x86_64 open-vm-tools-gosc-12.3.5-1.ph4.x86_64 open-vm-tools-sdmp-12.3.5-1.ph4.x86_64 parted-3.3-3.ph4.x86_64 patch-2.7.6-6.ph4.x86_64 pciutils-3.7.0-2.ph4.x86_64 pcre-8.44-4.ph4.x86_64 pcre-libs-8.44-4.ph4.x86_64 photon-release-4.0-2.ph4.noarch photon-repos-4.0-3.ph4.noarch pinentry-1.1.0-1.ph4.x86_64 pixman-0.40.0-2.ph4.x86_64 pkg-config-0.29.2-5.ph4.x86_64 popt-1.16-5.ph4.x86_64 procps-ng-3.3.17-2.ph4.x86_64 psmisc-23.3-1.ph4.x86_64 python3-3.10.11-7.ph4.x86_64 python3-alabaster-0.7.12-2.ph4.noarch python3-asn1crypto-1.4.0-2.ph4.noarch python3-attrs-20.3.0-3.ph4.noarch python3-babel-2.9.1-2.ph4.noarch python3-backports_abc-0.5-5.ph4.noarch python3-bcrypt-3.2.0-2.ph4.x86_64 python3-certifi-2023.11.17-1.ph4.noarch python3-cffi-1.14.3-3.ph4.x86_64 python3-chardet-4.0.0-1.ph4.noarch python3-charset-normalizer-2.0.9-1.ph4.noarch python3-configobj-5.0.6-6.ph4.noarch python3-cryptography-41.0.7-1.ph4.x86_64 python3-curses-3.10.11-7.ph4.x86_64 python3-distro-1.5.0-2.ph4.noarch python3-docutils-0.16-3.ph4.noarch python3-ecdsa-0.16.0-2.ph4.noarch python3-idna-2.10-2.ph4.noarch python3-imagesize-1.2.0-3.ph4.noarch python3-jinja2-3.1.2-1.ph4.noarch python3-jmespath-0.10.0-4.ph4.noarch python3-jsonpatch-1.26-2.ph4.noarch python3-jsonpointer-2.0-3.ph4.noarch python3-jsonschema-3.2.0-2.ph4.noarch python3-libs-3.10.11-7.ph4.x86_64 python3-libxml2-2.9.12-13.ph4.x86_64 python3-lxml-4.9.1-1.ph4.x86_64 python3-M2Crypto-0.38.0-1.ph4.x86_64 python3-markupsafe-2.1.1-1.ph4.x86_64 python3-mock-4.0.3-2.ph4.noarch python3-msgpack-1.0.2-1.ph4.x86_64 python3-netaddr-0.8.0-3.ph4.noarch python3-netifaces-0.10.9-3.ph4.x86_64 python3-nocasedict-1.0.2-2.ph4.noarch python3-nocaselist-1.0.4-2.ph4.noarch python3-oauthlib-3.1.0-2.ph4.noarch python3-packaging-20.4-4.ph4.noarch python3-pam-1.8.4-2.ph4.noarch python3-paramiko-2.10.3-5.ph4.noarch python3-pbr-5.5.1-2.ph4.noarch python3-pip-23.3.2-2.ph4.noarch python3-pip-wheel-23.3.2-2.ph4.noarch python3-ply-3.11-6.ph4.noarch python3-prettytable-0.7.2-8.ph4.noarch python3-psutil-5.7.3-3.ph4.x86_64 python3-pyasn1-0.4.8-2.ph4.noarch python3-pycparser-2.20-2.ph4.noarch python3-pycryptodome-3.12.0-3.ph4.x86_64 python3-pycryptodomex-3.9.9-3.ph4.x86_64 python3-Pygments-2.9.0-2.ph4.noarch python3-PyNaCl-1.4.0-2.ph4.x86_64 python3-pyOpenSSL-23.2.0-2.ph4.noarch python3-pyparsing-2.4.7-2.ph4.noarch python3-pyrsistent-0.17.3-3.ph4.x86_64 python3-pyserial-3.5-1.ph4.noarch python3-pytz-2020.4-3.ph4.noarch python3-pywbem-1.1.2-4.ph4.noarch python3-PyYAML-5.4.1-3.ph4.x86_64 python3-requests-2.26.0-2.ph4.noarch python3-resolvelib-0.5.5-1.ph4.noarch python3-setuptools-65.5.1-2.ph4.noarch python3-setuptools-wheel-65.5.1-2.ph4.noarch python3-six-1.15.0-4.ph4.noarch python3-snowballstemmer-2.0.0-2.ph4.noarch python3-sphinx-5.1.1-1.ph4.noarch python3-sphinxcontrib-applehelp-1.0.2-3.ph4.noarch python3-sphinxcontrib-devhelp-1.0.2-3.ph4.noarch python3-sphinxcontrib-htmlhelp-2.0.0-1.ph4.noarch python3-sphinxcontrib-jsmath-1.0.1-3.ph4.noarch python3-sphinxcontrib-qthelp-1.0.3-3.ph4.noarch python3-sphinxcontrib-serializinghtml-1.1.5-1.ph4.noarch python3-tornado-6.0.4-3.ph4.x86_64 python3-typing-3.7.4.3-2.ph4.noarch python3-urllib3-1.25.11-5.ph4.noarch python3-xml-3.10.11-7.ph4.x86_64 python3-yamlloader-1.1.0-2.ph4.noarch python3-zmq-23.2.0-1.ph4.x86_64 readline-7.0-3.ph4.x86_64 rpcsvc-proto-1.4.2-1.ph4.x86_64 rpm-4.16.1.3-18.ph4.x86_64 rpm-libs-4.16.1.3-18.ph4.x86_64 rpm-plugin-systemd-inhibit-4.16.1.3-18.ph4.x86_64 rsync-3.2.4-1.ph4.x86_64 rsyslog-8.2306.0-3.ph4.x86_64 salt3-3005.5-1.ph4.noarch salt3-minion-3005.5-1.ph4.noarch sed-4.8-3.ph4.x86_64 sg3_utils-1.44-2.ph4.x86_64 shadow-4.13-2.ph4.x86_64 shadow-libs-4.13-2.ph4.x86_64 shadow-tools-4.13-2.ph4.x86_64 slang-2.3.2-1.ph4.x86_64 sqlite-libs-3.38.5-4.ph4.x86_64 sshfs-3.7.0-4.ph4.x86_64 sshpass-1.10-1.ph4.x86_64 stig-hardening-1.5-2.ph4.noarch sudo-1.9.15p5-1.ph4.x86_64 sysstat-12.7.2-1.ph4.x86_64 systemd-247.13-12.ph4.x86_64 systemd-libs-247.13-12.ph4.x86_64 systemd-pam-247.13-12.ph4.x86_64 systemd-rpm-macros-247.13-12.ph4.noarch systemd-udev-247.13-12.ph4.x86_64 tar-1.34-5.ph4.x86_64 tcp_wrappers-7.6-7.ph4.x86_64 tdnf-3.3.9-3.ph4.x86_64 tdnf-cli-libs-3.3.9-3.ph4.x86_64 tomcat-template-8.5.97.0-1.vmw.22955628.x86_64 tzdata-2022g-1.ph4.noarch unzip-6.0-16.ph4.x86_64 util-linux-2.37.4-1.ph4.x86_64 util-linux-libs-2.37.4-1.ph4.x86_64 vim-9.0.2142-1.ph4.x86_64 vmware-casa-1.0.0-23529655.x86_64 vmware-jre-11.0.22-12.x86_64 VMware-Log-Insight-Agent-8.16.0-23229978.noarch VMware-Postgres-14.10.0-22941784.x86_64 VMware-Postgres-client-jdbc-14.10.0-22941784.noarch VMware-Postgres-contrib-14.10.0-22941784.x86_64 VMware-Postgres-extras-14.10.0-22941784.x86_64 VMware-Postgres-libs-14.10.0-22941784.x86_64 VMware-Postgres-pg_rewind-14.10.0-22941784.x86_64 VMware-Postgres-pg_top-14.10.0-22941784.x86_64 VMware-Postgres-plperl-14.10.0-22941784.x86_64 VMware-Postgres-server-14.10.0-22941784.x86_64 vmware-vcops-8.16.1-23529658.x86_64 vmware-vcopssuite-utilities-1.0.0-23529659.x86_64 vmware-vcops-web-admin-8.16.1-23529658.x86_64 vrops-init-8.16.1.0-23529656.noarch wget-1.21.3-1.ph4.x86_64 which-2.21-6.ph4.x86_64 xmlsec1-1.2.30-6.ph4.x86_64 xxhash-0.8.1-1.ph4.x86_64 xxhash-libs-0.8.1-1.ph4.x86_64 xz-5.2.5-2.ph4.x86_64 xz-libs-5.2.5-2.ph4.x86_64 zchunk-libs-1.1.7-3.ph4.x86_64 zip-3.0-3.ph4.x86_64 zlib-1.2.11-6.ph4.x86_64 zstd-1.5.2-2.ph4.x86_64 zstd-libs-1.5.2-2.ph4.x86_64

旧 8.16.1

admin@vrops02 [ ~ ]$ rpm -qa | sort ansible-2.14.12-2.ph4.noarch ansible-community-general-5.6.0-3.ph4.noarch ansible-posix-1.4.0-3.ph4.noarch apr-1.7.2-1.ph4.x86_64 apr-util-1.6.3-1.ph4.x86_64 attr-2.4.48-2.ph4.x86_64 audit-2.8.5-30.ph4.x86_64 autogen-libopts-5.18.16-4.ph4.x86_64 bash-5.0-4.ph4.x86_64 bc-1.07.1-4.ph4.x86_64 bindutils-9.16.48-1.ph4.x86_64 bridge-utils-1.6-1.ph4.x86_64 btrfs-progs-5.7-3.ph4.x86_64 bzip2-1.0.8-4.ph4.x86_64 bzip2-libs-1.0.8-4.ph4.x86_64 ca-certificates-20201001-4.ph4.x86_64 ca-certificates-pki-20201001-4.ph4.x86_64 cairo-1.17.2-6.ph4.x86_64 c-ares-1.19.1-2.ph4.x86_64 chkconfig-1.9-3.ph4.x86_64 chromium-123.0.6283.1-1.ph4.x86_64 cifs-utils-6.13-2.ph4.x86_64 cloud-init-23.4-4.ph4.noarch cmocka-1.1.5-3.ph4.x86_64 coreutils-selinux-9.1-2.ph4.x86_64 cpio-2.13-9.ph4.x86_64 cracklib-2.9.7-4.ph4.x86_64 cracklib-dicts-2.9.7-4.ph4.x86_64 cronie-1.5.5-1.ph4.x86_64 curl-8.1.2-7.ph4.x86_64 curl-libs-8.1.2-7.ph4.x86_64 cyrus-sasl-2.1.27-7.ph4.x86_64 dbus-1.13.18-3.ph4.x86_64 device-mapper-2.03.10-3.ph4.x86_64 device-mapper-event-2.03.10-3.ph4.x86_64 device-mapper-event-libs-2.03.10-3.ph4.x86_64 device-mapper-libs-2.03.10-3.ph4.x86_64 dhcp-client-4.4.2-6.ph4.x86_64 dhcp-libs-4.4.2-6.ph4.x86_64 distrib-compat-0.1-2.ph4.x86_64 dracut-050-13.ph4.x86_64 drpm-0.5.0-6.ph4.x86_64 e2fsprogs-1.46.5-2.ph4.x86_64 e2fsprogs-libs-1.46.5-2.ph4.x86_64 elfutils-0.181-7.ph4.x86_64 elfutils-libelf-0.181-7.ph4.x86_64 ethtool-5.10-1.ph4.x86_64 expat-2.2.9-11.ph4.x86_64 expat-libs-2.2.9-11.ph4.x86_64 file-5.39-2.ph4.x86_64 file-libs-5.39-2.ph4.x86_64 filesystem-1.1-4.ph4.x86_64 findutils-4.7.0-1.ph4.x86_64 finger-0.17-3.ph4.x86_64 flex-2.6.4-3.ph4.x86_64 fontconfig-2.13.1-5.ph4.x86_64 fping-5.0-1.ph4.x86_64 freetype2-2.13.0-1.ph4.x86_64 fuse-2.9.9-1.ph4.x86_64 fuse3-3.9.4-4.ph4.x86_64 gawk-5.1.1-1.ph4.x86_64 gc-8.0.4-2.ph4.x86_64 gdbm-1.19-1.ph4.x86_64 gettext-0.21-3.ph4.x86_64 glib-2.68.4-1.ph4.x86_64 glibc-2.32-15.ph4.x86_64 glibc-i18n-2.32-15.ph4.x86_64 glibc-iconv-2.32-15.ph4.x86_64 glibc-lang-2.32-15.ph4.x86_64 gmp-6.2.0-1.ph4.x86_64 gnupg-2.2.23-4.ph4.x86_64 gnutls-3.7.10-2.ph4.x86_64 gpg-pubkey-66fd4949-4803fe57 gpg-pubkey-8a6a826d-596882ca grep-3.4-2.ph4.x86_64 grub2-2.06-12.ph4.x86_64 grub2-theme-4.0-2.ph4.noarch guile-2.0.13-4.ph4.x86_64 gzip-1.12-2.ph4.x86_64 haveged-1.9.18-1.ph4.x86_64 httpd-2.4.58-2.ph4.x86_64 httpd-mod_jk-1.2.48-9.ph4.x86_64 iana-etc-2.30-2.ph4.noarch initramfs-2.0-7.ph4.x86_64 initscripts-10.04-2.ph4.x86_64 inotify-tools-3.13-2.ph4.x86_64 ipcalc-0.4.1-1.ph4.x86_64 iproute2-5.10.0-4.ph4.x86_64 iptables-1.8.9-3.ph4.x86_64 iputils-20200821-3.ph4.x86_64 irqbalance-1.7.0-4.ph4.x86_64 jansson-2.13.1-1.ph4.x86_64 kbd-2.3.0-2.ph4.x86_64 kmod-27-1.ph4.x86_64 krb5-1.17-10.ph4.x86_64 less-551-2.ph4.x86_64 libacl-2.2.53-2.ph4.x86_64 libaio-0.3.110-3.ph4.x86_64 libarchive-3.4.3-10.ph4.x86_64 libassuan-2.5.3-2.ph4.x86_64 libatomic_ops-7.6.10-2.ph4.x86_64 libcap-2.43-3.ph4.x86_64 libcap-ng-0.8-2.ph4.x86_64 libedit-3.1.20210910-2.ph4.x86_64 libestr-0.1.11-2.ph4.x86_64 libevent-2.1.12-1.ph4.x86_64 libfastjson-0.99.8-1.ph4.x86_64 libffi-3.3-1.ph4.x86_64 libgcc-10.5.0-1.ph4.x86_64 libgcrypt-1.9.4-2.ph4.x86_64 libgomp-10.5.0-1.ph4.x86_64 libgpg-error-1.39-1.ph4.x86_64 libksba-1.4.0-4.ph4.x86_64 liblogging-1.0.6-2.ph4.x86_64 libltdl-2.4.6-3.ph4.x86_64 libmicrohttpd-0.9.76-2.ph4.x86_64 libmnl-1.0.4-4.ph4.x86_64 libmspack-0.10.1alpha-3.ph4.x86_64 libnftnl-1.2.1-1.ph4.x86_64 libnsl-1.3.0-2.ph4.x86_64 libnuma-2.0.14-3.ph4.x86_64 libpcap-1.10.0-1.ph4.x86_64 libpng-1.6.37-2.ph4.x86_64 libpwquality-1.4.2-3.ph4.x86_64 librelp-1.8.0-5.ph4.x86_64 libseccomp-2.5.0-3.ph4.x86_64 libselinux-3.3-1.ph4.x86_64 libsepol-3.3-1.ph4.x86_64 libsolv-0.7.19-5.ph4.x86_64 libssh2-1.11.0-1.ph4.x86_64 libstdc++-10.5.0-1.ph4.x86_64 libtasn1-4.14-2.ph4.x86_64 libtirpc-1.2.6-4.ph4.x86_64 libtool-2.4.6-3.ph4.x86_64 libunistring-0.9.10-2.ph4.x86_64 libuv-1.45.0-2.ph4.x86_64 libX11-1.8.5-2.ph4.x86_64 libXau-1.0.9-1.ph4.x86_64 libxcb-1.15-1.ph4.x86_64 libXdmcp-1.1.3-1.ph4.x86_64 libXext-1.3.4-3.ph4.x86_64 libxml2-2.9.12-13.ph4.x86_64 libxml2-devel-2.9.12-13.ph4.x86_64 libxslt-1.1.34-7.ph4.x86_64 libyaml-0.2.5-1.ph4.x86_64 linux-5.10.210-2.ph4.x86_64 Linux-PAM-1.5.3-2.ph4.x86_64 logrotate-3.21.0-1.ph4.x86_64 lsof-4.95.0-1.ph4.x86_64 lsscsi-0.31-1.ph4.x86_64 lua-5.4.4-3.ph4.x86_64 lvm2-2.03.10-3.ph4.x86_64 lvm2-libs-2.03.10-3.ph4.x86_64 lz4-1.9.2-2.ph4.x86_64 lzo-2.10-1.ph4.x86_64 m4-1.4.18-3.ph4.x86_64 motd-0.1.3-7.ph4.noarch mpfr-4.1.0-2.ph4.x86_64 ncurses-6.2-6.ph4.x86_64 ncurses-compat-6.2-6.ph4.x86_64 ncurses-libs-6.2-6.ph4.x86_64 ncurses-terminfo-6.2-6.ph4.x86_64 nettle-3.7.3-1.ph4.x86_64 net-tools-1.60-13.ph4.x86_64 newt-0.52.21-1.ph4.x86_64 nghttp2-1.57.0-1.ph4.x86_64 npth-1.6-1.ph4.x86_64 nspr-4.32-1.ph4.x86_64 nss-3.72-4.ph4.x86_64 nss-libs-3.72-4.ph4.x86_64 ntp-4.2.8p16-1.ph4.x86_64 ntsysv-1.9-3.ph4.x86_64 numactl-2.0.14-3.ph4.x86_64 openldap-2.4.57-4.ph4.x86_64 open-sans-fonts-1.10-1.ph4.noarch openssh-8.9p1-6.ph4.x86_64 openssh-clients-8.9p1-6.ph4.x86_64 openssh-server-8.9p1-6.ph4.x86_64 openssl-3.0.13-2.ph4.x86_64 openssl-c_rehash-3.0.13-2.ph4.x86_64 openssl-fips-provider-3.0.8-1.ph4.x86_64 open-vm-tools-12.3.5-1.ph4.x86_64 open-vm-tools-gosc-12.3.5-1.ph4.x86_64 open-vm-tools-sdmp-12.3.5-1.ph4.x86_64 parted-3.3-3.ph4.x86_64 patch-2.7.6-6.ph4.x86_64 pciutils-3.7.0-2.ph4.x86_64 pcre-8.44-4.ph4.x86_64 pcre-libs-8.44-4.ph4.x86_64 photon-release-4.0-2.ph4.noarch photon-repos-4.0-3.ph4.noarch pinentry-1.1.0-1.ph4.x86_64 pixman-0.40.0-2.ph4.x86_64 pkg-config-0.29.2-5.ph4.x86_64 popt-1.16-5.ph4.x86_64 procps-ng-3.3.17-2.ph4.x86_64 psmisc-23.3-1.ph4.x86_64 python3-3.10.11-7.ph4.x86_64 python3-alabaster-0.7.12-2.ph4.noarch python3-asn1crypto-1.4.0-2.ph4.noarch python3-attrs-20.3.0-3.ph4.noarch python3-babel-2.9.1-2.ph4.noarch python3-backports_abc-0.5-5.ph4.noarch python3-bcrypt-3.2.0-2.ph4.x86_64 python3-certifi-2023.11.17-1.ph4.noarch python3-cffi-1.14.3-3.ph4.x86_64 python3-chardet-4.0.0-1.ph4.noarch python3-charset-normalizer-2.0.9-1.ph4.noarch python3-configobj-5.0.6-6.ph4.noarch python3-cryptography-41.0.7-1.ph4.x86_64 python3-curses-3.10.11-7.ph4.x86_64 python3-distro-1.5.0-2.ph4.noarch python3-docutils-0.16-3.ph4.noarch python3-ecdsa-0.16.0-2.ph4.noarch python3-idna-2.10-2.ph4.noarch python3-imagesize-1.2.0-3.ph4.noarch python3-jinja2-3.1.2-1.ph4.noarch python3-jmespath-0.10.0-4.ph4.noarch python3-jsonpatch-1.26-2.ph4.noarch python3-jsonpointer-2.0-3.ph4.noarch python3-jsonschema-3.2.0-2.ph4.noarch python3-libs-3.10.11-7.ph4.x86_64 python3-libxml2-2.9.12-13.ph4.x86_64 python3-lxml-4.9.1-1.ph4.x86_64 python3-M2Crypto-0.38.0-1.ph4.x86_64 python3-markupsafe-2.1.1-1.ph4.x86_64 python3-mock-4.0.3-2.ph4.noarch python3-msgpack-1.0.2-1.ph4.x86_64 python3-netaddr-0.8.0-3.ph4.noarch python3-netifaces-0.10.9-3.ph4.x86_64 python3-nocasedict-1.0.2-2.ph4.noarch python3-nocaselist-1.0.4-2.ph4.noarch python3-oauthlib-3.1.0-2.ph4.noarch python3-packaging-20.4-4.ph4.noarch python3-pam-1.8.4-2.ph4.noarch python3-paramiko-2.10.3-5.ph4.noarch python3-pbr-5.5.1-2.ph4.noarch python3-pip-23.3.2-2.ph4.noarch python3-pip-wheel-23.3.2-2.ph4.noarch python3-ply-3.11-6.ph4.noarch python3-prettytable-0.7.2-8.ph4.noarch python3-psutil-5.7.3-3.ph4.x86_64 python3-pyasn1-0.4.8-2.ph4.noarch python3-pycparser-2.20-2.ph4.noarch python3-pycryptodome-3.12.0-3.ph4.x86_64 python3-pycryptodomex-3.9.9-3.ph4.x86_64 python3-Pygments-2.9.0-2.ph4.noarch python3-PyNaCl-1.4.0-2.ph4.x86_64 python3-pyOpenSSL-23.2.0-2.ph4.noarch python3-pyparsing-2.4.7-2.ph4.noarch python3-pyrsistent-0.17.3-3.ph4.x86_64 python3-pyserial-3.5-1.ph4.noarch python3-pytz-2020.4-3.ph4.noarch python3-pywbem-1.1.2-4.ph4.noarch python3-PyYAML-5.4.1-3.ph4.x86_64 python3-requests-2.26.0-2.ph4.noarch python3-resolvelib-0.5.5-1.ph4.noarch python3-setuptools-65.5.1-2.ph4.noarch python3-setuptools-wheel-65.5.1-2.ph4.noarch python3-six-1.15.0-4.ph4.noarch python3-snowballstemmer-2.0.0-2.ph4.noarch python3-sphinx-5.1.1-1.ph4.noarch python3-sphinxcontrib-applehelp-1.0.2-3.ph4.noarch python3-sphinxcontrib-devhelp-1.0.2-3.ph4.noarch python3-sphinxcontrib-htmlhelp-2.0.0-1.ph4.noarch python3-sphinxcontrib-jsmath-1.0.1-3.ph4.noarch python3-sphinxcontrib-qthelp-1.0.3-3.ph4.noarch python3-sphinxcontrib-serializinghtml-1.1.5-1.ph4.noarch python3-tornado-6.0.4-3.ph4.x86_64 python3-typing-3.7.4.3-2.ph4.noarch python3-urllib3-1.25.11-5.ph4.noarch python3-xml-3.10.11-7.ph4.x86_64 python3-yamlloader-1.1.0-2.ph4.noarch python3-zmq-23.2.0-1.ph4.x86_64 readline-7.0-3.ph4.x86_64 rpcsvc-proto-1.4.2-1.ph4.x86_64 rpm-4.16.1.3-18.ph4.x86_64 rpm-libs-4.16.1.3-18.ph4.x86_64 rpm-plugin-systemd-inhibit-4.16.1.3-18.ph4.x86_64 rsync-3.2.4-1.ph4.x86_64 rsyslog-8.2306.0-3.ph4.x86_64 salt3-3005.5-1.ph4.noarch salt3-minion-3005.5-1.ph4.noarch sed-4.8-3.ph4.x86_64 sg3_utils-1.44-2.ph4.x86_64 shadow-4.13-2.ph4.x86_64 shadow-libs-4.13-2.ph4.x86_64 shadow-tools-4.13-2.ph4.x86_64 slang-2.3.2-1.ph4.x86_64 sqlite-libs-3.38.5-4.ph4.x86_64 sshfs-3.7.0-4.ph4.x86_64 sshpass-1.10-1.ph4.x86_64 stig-hardening-1.5-2.ph4.noarch sudo-1.9.15p5-1.ph4.x86_64 sysstat-12.7.2-1.ph4.x86_64 systemd-247.13-12.ph4.x86_64 systemd-libs-247.13-12.ph4.x86_64 systemd-pam-247.13-12.ph4.x86_64 systemd-rpm-macros-247.13-12.ph4.noarch systemd-udev-247.13-12.ph4.x86_64 tar-1.34-5.ph4.x86_64 tcp_wrappers-7.6-7.ph4.x86_64 tdnf-3.3.9-3.ph4.x86_64 tdnf-cli-libs-3.3.9-3.ph4.x86_64 tomcat-template-8.5.97.0-1.vmw.22955628.x86_64 tzdata-2022g-1.ph4.noarch unzip-6.0-16.ph4.x86_64 util-linux-2.37.4-1.ph4.x86_64 util-linux-libs-2.37.4-1.ph4.x86_64 vim-9.0.2142-1.ph4.x86_64 vmware-casa-1.0.0-23529655.x86_64 vmware-jre-11.0.22-12.x86_64 VMware-Log-Insight-Agent-8.16.0-23229978.noarch VMware-Postgres-14.10.0-22941784.x86_64 VMware-Postgres-client-jdbc-14.10.0-22941784.noarch VMware-Postgres-contrib-14.10.0-22941784.x86_64 VMware-Postgres-extras-14.10.0-22941784.x86_64 VMware-Postgres-libs-14.10.0-22941784.x86_64 VMware-Postgres-pg_rewind-14.10.0-22941784.x86_64 VMware-Postgres-pg_top-14.10.0-22941784.x86_64 VMware-Postgres-plperl-14.10.0-22941784.x86_64 VMware-Postgres-server-14.10.0-22941784.x86_64 vmware-vcops-8.16.1-23529658.x86_64 vmware-vcopssuite-utilities-1.0.0-23529659.x86_64 vmware-vcops-web-admin-8.16.1-23529658.x86_64 vrops-init-8.16.1.0-23529656.noarch wget-1.21.3-1.ph4.x86_64 which-2.21-6.ph4.x86_64 xmlsec1-1.2.30-6.ph4.x86_64 xxhash-0.8.1-1.ph4.x86_64 xxhash-libs-0.8.1-1.ph4.x86_64 xz-5.2.5-2.ph4.x86_64 xz-libs-5.2.5-2.ph4.x86_64 zchunk-libs-1.1.7-3.ph4.x86_64 zip-3.0-3.ph4.x86_64 zlib-1.2.11-6.ph4.x86_64 zstd-1.5.2-2.ph4.x86_64 zstd-libs-1.5.2-2.ph4.x86_64

diff ってみても完全に一致。

$ diff 8.16.0hf.txt 8.16.1hf.txt $

ソースバージョンは何であれ、適用後は同じバージョンになるで良さそう。

バージョニングとしては

- 8.16

- 8.16.1

- 8.16.1 HF1

で、8.16 HF1 は無い(それは 8.16.1 HF1 とな同じ) と理解しておく。

そもそも

それぞれのバージョンの OVA ファイルより HotFix(.pak)の方がサイズが大きいかったりすんだよなぁ…

これで修正箇所だけの差分ですと言われるとちょっとねぇ。

これで修正箇所だけの差分ですと言われるとちょっとねぇ。